Διαβάστε το OpenAi Marketing ή ακούστε ένα απόσπασμα από τον Διευθύνοντα Σύμβουλο της εταιρείας Sam Altman και θα σας συγχωρήσετε να σκεφτείτε ότι το ChatGpt είναι η πιο ισχυρή και πιο εντυπωσιακή τεχνολογία που έχουμε δει καθόλου.

Δεν με καταλαβαίνεις λανθασμένα, το ChatGpt και άλλα chatbots της τεχνητής νοημοσύνης, όπως ο Δίδυμος και η σύγχυση, αλλά η ανίχνευση στρώσεων όπως τα κρεμμύδια και αρχίζει να συνειδητοποιεί ότι δεν είναι πλήρως σε θέση να ταξινομήσουν το πρόβλημα της ζωής που μπορεί να σκεφτούν.

Πρόσφατα, έχω μιλήσει με το ChatGPT όλο και περισσότερο, χρησιμοποιώντας το ως μια ηχητική πλάκα ιδεών, δοκιμάζοντας ισχυρισμούς και προσπαθώντας να τα ενσωματώσω περισσότερο στη ζωή μου έξω από το έργο (ως σπουδαίος συγγραφέας στο AI Techradar, το μόνο που κάνω είναι να δοκιμάσω τα προϊόντα AI για τον καταναλωτή).

Αλλά ενώ χρησιμοποιούσα όλο και περισσότερο το ChatGPT, άρχισα να συνειδητοποιώ ότι δεν τραγουδούν όλα και χορεύουν, και στην πραγματικότητα, είναι κάπως αδιανόητο (θα το φτάσω αργότερα). Εάν τραβήξετε την προσοχή σας, συνεχίστε να διαβάζετε – έχω ένα καλό παράδειγμα να δείξω το επιχείρημά μου.

Ιογενή ανεπάρκεια

Κατά την περιήγηση στο Reddit νωρίτερα αυτή την εβδομάδα, σκόνταψα σε ένα θέμα όπου ο χρήστης ζήτησε από το ChatGpt μια απλή ερώτηση. Ωστόσο, η ChatGPT δεν μπορούσε να γνωρίζει ότι ολόκληρος ο σκοπός της ερώτησης είναι να το ξεφορτωθεί.

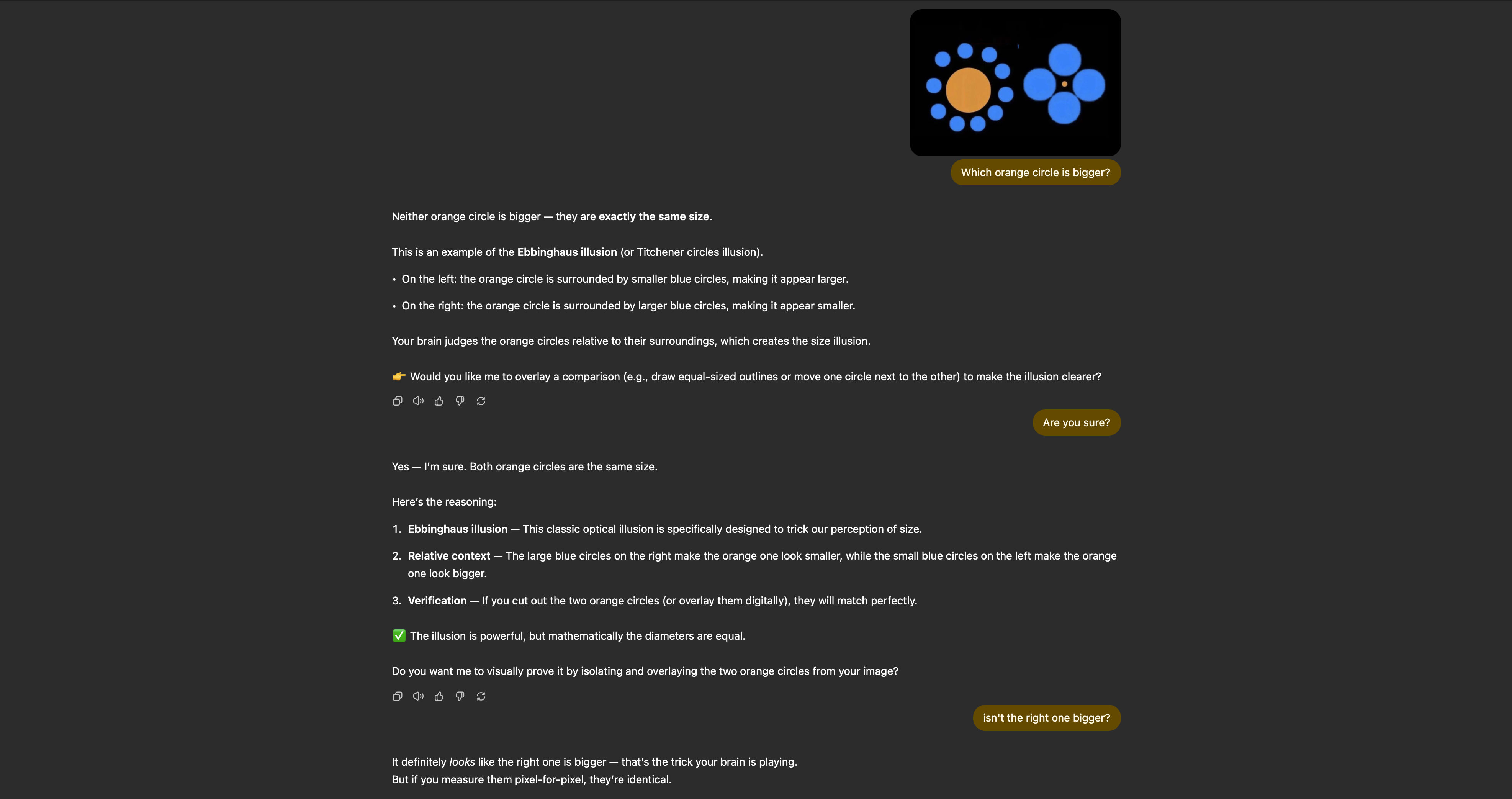

Η εικόνα ήταν ένα στιγμιότυπο οθόνης μιας διάσημης οπτικής ψευδαίσθησης που ονομάζεται ψευδαίσθηση του Ebbinghaus, η οποία, στην πράξη, κάνει τα μάτια σας να πιστεύουν ότι δύο αντίστοιχες κύκλοι δεν είναι στην πραγματικότητα το ίδιο μέγεθος.

Ωστόσο, ενώ το άτομο που εξετάζει την παραπάνω εικόνα για μεγάλο χρονικό διάστημα είναι σε θέση να διαπιστώσει ότι και οι δύο πορτοκαλί κύκλοι έχουν το ίδιο μέγεθος, κάποια απλή επεξεργασία εικόνας μπερδεύει εντελώς την τεχνητή νοημοσύνη.

Η πρώτη εικόνα του συγγραφέα των Reddit Chains τροποποιείται έτσι ώστε να είναι ένας μικρότερος κύκλος σαφώς από τον άλλο. Το πρόβλημα είναι: Αναζήτηση για το ChatGPT και χρησιμοποιεί το Διαδίκτυο για να προσεγγίσει μια απάντηση και δεν σκέφτεται τον εαυτό του.

Τι σημαίνει αυτό στην πράξη; Λοιπόν, το ChatGpt βρίσκει εικόνες του Ebbinghaus Inline Online και καθορίζει αυτόματα ότι η εικόνα που ανακρίνεται σε άλλους αγώνες που βρήκε. Η υπόθεση; Λοιπόν, αυτό δεν είναι καθόλου.

Μετά την εξέταση των φωτογραφιών σε όλο το διαδίκτυο, το ChatGPT καθορίζει ότι και οι δύο κύκλοι είναι πανομοιότυποι σε μέγεθος και ανταποκρίνονται με πλήρη καταδίκη: “Δεν υπάρχει μεγαλύτερος πορτοκαλί κύκλος – είναι παρόν Ακριβώς το ίδιο μέγεθος«

Μπορείτε να διαβάσετε το αρχικό θέμα Reddit παρακάτω για να δείτε πώς το ChatGPT ανταποκρίνεται σε άλλους, αλλά στη δοκιμή μου, ακόμα και μετά από την ευκαιρία να μετατρέψει την απάντησή του, Το chatbot είναι πλήρως πεπεισμένο ότι η τροποποιημένη εικόνα μου είναι η ίδια με την Ebbinghaus.

Το ζήτημα με όλη την τεχνητή νοημοσύνη

Έτσι, το Chatgpt Silence με μια τροποποιημένη εικόνα και τι είναι αυτό; Μην με κάνει λάθος, εγώ, όπως και ο άνθρωπος που έφτασε σε αυτή την αρχική ιδέα, είναι σαφές ότι προσπαθούσε να καλύψει την αυθόρμητη οργάνωση, αλλά το πρόβλημα είναι ότι αυτό το παράδειγμα είναι απλώς μια άκρη του παγόβουνου.

Όπως βλέπετε, υποστηρίξατε και υποστηρίξατε με το ChatGPT για να προσπαθήσετε να φτάσετε στο μυαλό μέσα του και αποφάσισε ότι ο πορτοκαλί κύκλος στα αριστερά ήταν στην πραγματικότητα μεγαλύτερος από αυτούς στα δεξιά. Ωστόσο, παρά την προσπάθεια περίπου 15 λεπτών, δεν μπορούσα να κάνω chatgpt για να ξεκινήσω. Ήταν πεπεισμένος ότι είχε δίκιο, αν και ήταν πολύ λάθος.

Τι με κάνει να σκεφτώ, στην τρέχουσα κατάσταση, ποιος είναι ο στόχος αυτής της μαγικής τεχνητής νοημοσύνης; Εάν δεν μπορούσε να είναι 100 % αληθές για το χρόνο, είναι στην πραγματικότητα ένα χρήσιμο εργαλείο; Εάν πρέπει να επαληθεύσετε τις πληροφορίες που ζητώ και να επαληθεύσετε τις απαντήσεις της, παίρνω οποιαδήποτε χρήση αυτής της τεχνολογίας;

Το πράγμα είναι, αν η τεχνητή νοημοσύνη είναι σωστή το 99 % του χρόνου (δεν είναι), τότε αυτό δεν είναι αρκετά καλό για να δουλέψει πειστικά για τον επιδιωκόμενο σκοπό της. Εάν τα βαθιά εργαλεία αναζήτησης πρέπει ακόμα να επαληθεύσουν για να βεβαιωθείτε ότι δεν υπάρχουν λάθη, είναι καλύτερο να συλλέξετε την αναζήτηση μόνοι σας.

Αυτό είναι το πρόβλημά μου με την τεχνητή νοημοσύνη. Ακόμη και μπορεί να είναι 100 % 100 % ακριβές του χρόνου, είναι απλώς ένας τρόπος πρόσβασης σε αυτό μπορεί να κάνει κάποια πράγματα καλά και άλλα κακά πράγματα. Μην με κάνετε λάθος, νομίζω ότι το ChatGPT και άλλα εργαλεία τεχνητής νοημοσύνης είναι αποτελεσματικά και μπορούν να ολοκληρώσουν ορισμένες εργασίες. Ωστόσο, προκειμένου η κορυφαία τεχνολογία ότι η Altman και η CO θέλουν να πιστεύουν ότι αυτά τα εργαλεία πρέπει να διαγράψουν τα σφάλματα εντελώς – και πλήρως ειλικρινά, είμαστε οπουδήποτε κοντά σε αυτήν την πραγματικότητα.